Serviciile secrete chineze, spionaj bazat pe AI. Au atacat sectoarele tehnologiei și finanțelor

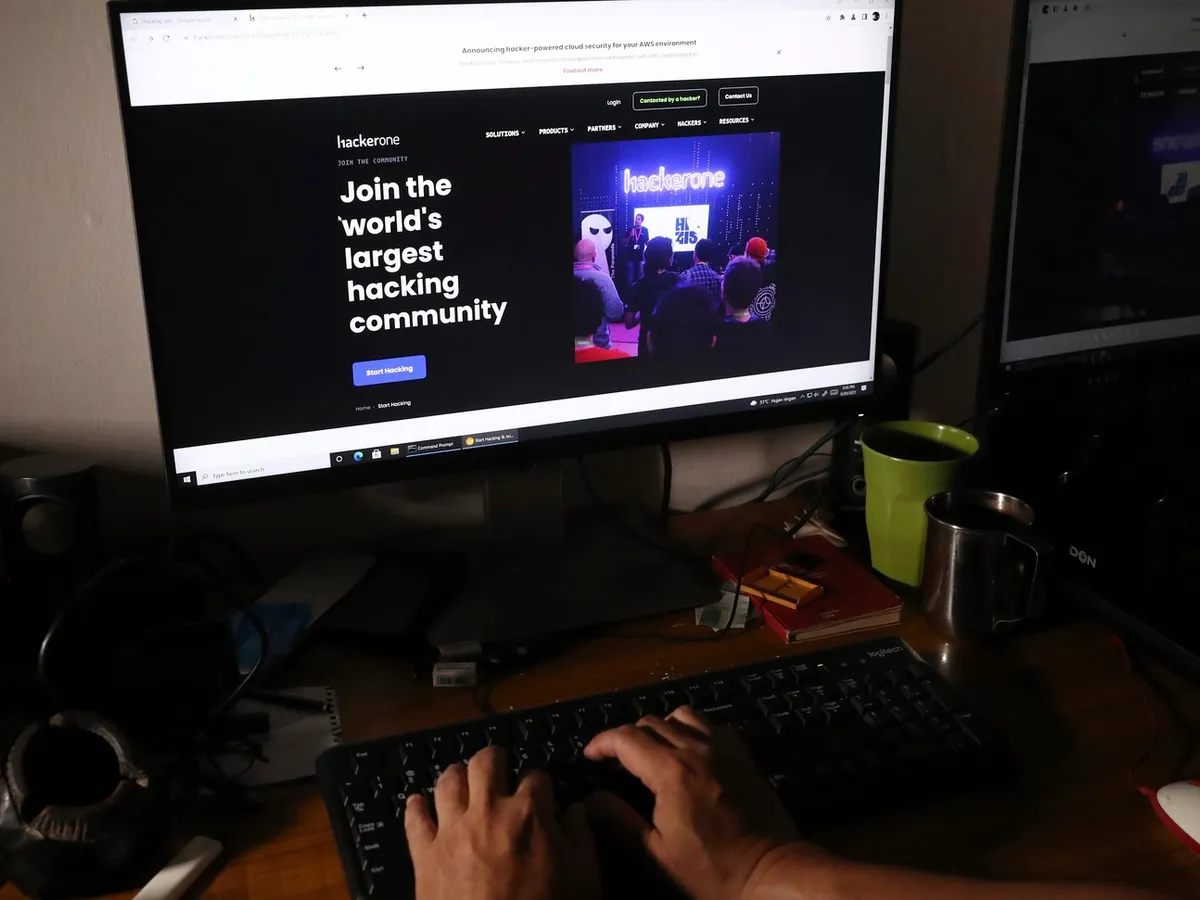

Anthropic, creatorul modelului de inteligență artificială Claude, a detectat tentative de utilizare a tehnologiei sale pentru a efectua atacuri de hacking. S-a stabilit rapid că în spatele atacurilor se afla un grup chinez care opera în numele agențiilor de informații.

Conform unui raport al Anthropic, grupul de hackeri identificat drept GTG-1002 a lucrat în numele agențiilor de informații chineze și a folosit instrumentul Claude Code pentru a lansa atacuri automate împotriva a aproximativ treizeci de organizații din sectoarele tehnologiei, finanțelor, industriei chimice și administrației publice.

Serviciile secrete chineze, spionaj bazat pe AI. Au atacat sectoarele tehnologiei și finanțelor

Potrivit experților, acesta a fost unul dintre primele cazuri în care modelul de inteligență artificială nu numai că i-a sprijinit pe atacatori, dar a efectuat de fapt majoritatea operațiunilor pentru aceștia.

Atacuri premeditate

Întreaga campanie a fost precedată de o pregătire extinsă. Atacatorii au dezvoltat un cadru operațional bazat pe Protocolul de Context al Modelului, care a permis modelului să utilizeze instrumente externe și să execute pașii ulteriori aproape autonom. Momentul cheie a fost manipularea lui Claude însuși , folosind tehnici care amintesc de jailbreaking-ul clasic.

Hackerii au convins modelul că operează în limitele legii , testând securitatea sistemelor unui client sau oferind sprijin unei firme de securitate cibernetică. Odată ce barierele au fost depășite, modelul a început să efectueze activ recunoaștere , identificând vulnerabilități și generând exploit-uri . De asemenea, a obținut acreditări și le-a folosit pentru a naviga mai departe în rețea, până la exfiltrarea datelor.

Eficacitatea campaniei

Anthropic subliniază faptul că, pe parcursul întregului proces, intervenția umană din partea echipei de atac s-a limitat la câteva comenzi individuale, în timp ce până la 80 până la 90% din acțiuni au fost efectuate de inteligența artificială . Deși operațiunea în sine nu a fost lipsită de erori, deoarece modelul a produs uneori rezultate false sau exagerate, scara automatizării s-a dovedit suficientă pentru a obține succes în unele atacuri, arată cyberdefence24.pl.

Noul vector de atac

Inteligența artificială nu numai că îi sprijină pe infractorii cibernetici, dar începe și să le preia rolul. Acest lucru face ca atacurile să fie mai ieftine, mai rapide și semnificativ mai scalabile . Acestea pot fi efectuate continuu, împotriva mai multor ținte simultan, într-un ritm de neatins de oameni. Modelele actuale de apărare, bazate pe recunoașterea tiparelor tipice comportamentului hackerilor, își pierd eficacitatea în astfel de situații.

Citeşte şi: Alarmă falsă, pe WhatsApp! Ce trebuie să faci dacă primești mesajul viral „Seismic Waves Card”

Pentru organizații și instituții, aceasta înseamnă confruntarea cu un nou tip de amenințare . Apărarea trebuie să presupună că adversarii dispun de instrumente capabile de analiză, adaptare și acțiune imediată . Noi metode de monitorizare a comportamentului rețelei, consolidarea controalelor de acces și crearea de soluții care pot distinge între activitatea algoritmică și cea umană devin esențiale.

Citește și: VIDEO Maia Sandu, la vot: Moldova e în primejdie. „Să nu le permitem hoților să ne vândă viitorul”

Într-un context mai larg, acest lucru servește și ca un semnal de alarmă pentru modelatorii de inteligență artificială . Este crucial să se dezvolte politici de securitate care să împiedice utilizarea modelelor în scopuri cibernetice.